group-telegram.com/campcode/7878

Last Update:

Вы не готовы: «думающие» модели на самом деле… не думают

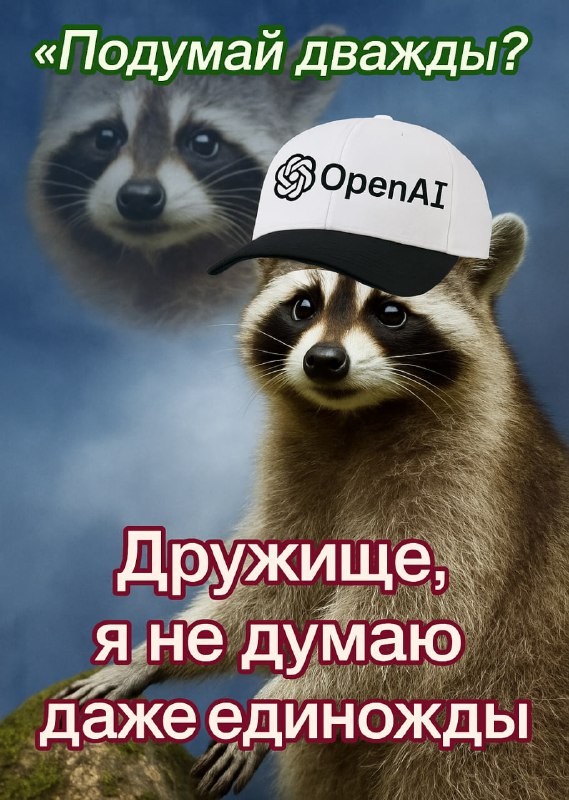

Apple неожиданно выпустили исследование, в котором они изучали, как работает цепочка размышлений в популярных CoT-моделях вроде Gemini 2.5 Pro, OpenAI o3 и DeepSeek R1.

Тестировали на логических головоломках, таких как Ханойские башни или загадка про волка, козу и капусту, постепенно усложняя их.

Результат УБИЛ:

— TL;DR: все модели пытаются прикинуться, что «думают», но на самом деле просто ищут похожие задачи в своей базе данных. AGI не будет

— Нашлась интересная проблема с overthinking: если задачка достаточно простая, модель быстро находит ответ, а потом тратит кредиты, проверяя другие варианты, из-за чего иногда случайно выдаёт неправильный ответ;

— Модели с большим бюджетом на размышления не так эффективны, как кажется — если задачка слишком сложная, нейросети просто быстрее «опускают руки». Даже бесконечный бюджет на размышления не поможет пробить барьер сложности;

— Few-shot prompting (когда вы даёте примеры решения вашей задачи) с таким типом моделей неэффективен: даже если расписать пошаговый алгоритм решения, модель всё равно не справится со слишком сложной задачей;

— Ну и самое интересное: модели почти идеально справились с Ханойскими башнями, даже когда для решения нужно было прописать более 100 (!) шагов. А вот в очень простой задаче про перевозку волка, козы и капусты модели начинали нести чушь уже на 4 шаге. Разгадка проста: детская загадка с рекой не так часто встречалась в тренировочном датасете моделей.

Интересно, что Apple подкололи всех своих конкурентов примерно за сутки до WWDC 2025. А сами что-то покажут завтра?