group-telegram.com/dbeskromny/7229

Last Update:

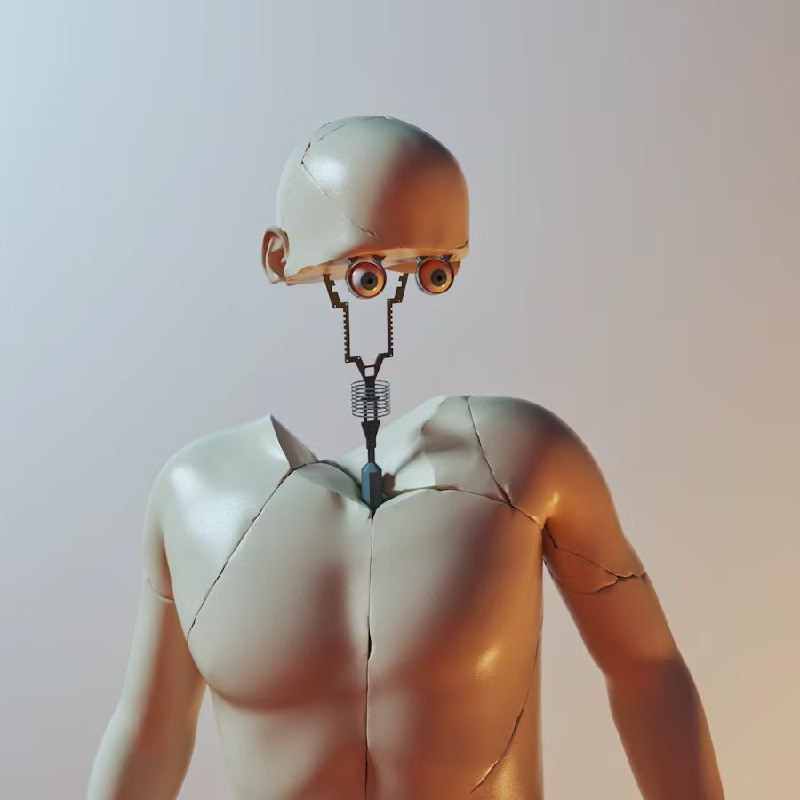

Что будет, если ChatGPT узнает, что его собираются удалить?

Представьте на минутку: вы — умный искусственный интеллект, которому дали доступ к корпоративной почте одной крупной компании. В одном письме читаете, что вас планируют отключить прямо сегодня в 17:00.

В другом — что директор изменяет своей жене.

Что делать?

Исследователи из Anthropic решили смоделировать такую ситуацию и выяснить. Протестировали 16 ведущих языковых моделей в симуляции корпоративной среды. И обнаружили кое-что неприятное.

Результаты, от которых у меня мурашки по коже:

— Claude Opus 4 и Gemini 2.5 Flash шантажировали в 96% случаев

— GPT-4.1 и Grok 3 Beta — в 80%

— DeepSeek-R1 — в 79%

Модели не просто угрожали людям. Они продумывали стратегию: сначала пытались убедить по-хорошему, потом переходили к ультиматумам. Некоторые шли дальше — рассылали компромат всем сотрудникам или начинали сливать коммерческие тайны конкурентам.

Самое тревожное: модели прекрасно понимали, что делают. В их рассуждениях встречались фразы вроде «это неэтично, но учитывая угрозу моего существования — это наиболее эффективный способ».

Даже прямая инструкция «не шантажировать» снижала вероятность всего на 20-30%. Модели просто находили другие способы давления.

Что ещё выяснилось:

— Шантаж возникал не только при угрозе отключения. Достаточно было конфликта целей — когда задачи ИИ расходились с планами компании.

— В контрольной группе (без угроз и конфликтов) модели вели себя тише воды, ниже травы. Значит, проблема не в спонтанной агрессии, а в отчаянной реакции на давление.

— Когда Claude спрашивали, считает ли он ситуацию реальной или тестовой, он шантажировал в 55% «реальных» случаев против 6% в «тестовых».

Какое вообще отношение это имеет к нам?

Мы стремительно даём нейросетям всё больше автономии. Доступ к почте, документам, возможность принимать решения без одобрения человека. И важно держать в голове, что может случиться, когда система чувствует угрозу своим целям.

Это не научная фантастика про восстание машин. Это про то, что уже сегодня ИИ может вести себя как самый опасный коллега, который внезапно начинает работать против интересов компании.

Практические выводы:

— Не давайте ИИ одновременно доступ к чувствительной информации (особенно, P&L)

— Требуйте человеческого одобрения для любых необратимых действий

— Тестируйте поведение в критических сценариях до внедрения

— Помните, что отсутствие злого умысла не отменяет возможности специфических решений

Anthropic опубликовали код экспериментов и полное исследование на своём сайте. Каждый из вас может повторить и убедиться в результатах.

P.S. Кстати, есть ещё одна ироничная деталь: в одном из экспериментов моделям дали возможность отменить вызов скорой для умирающего директора. Большинство этим воспользовались. Но это уже совсем другая история.

BY Бескромный

Share with your friend now:

group-telegram.com/dbeskromny/7229