group-telegram.com/misha_writes_code/151

Last Update:

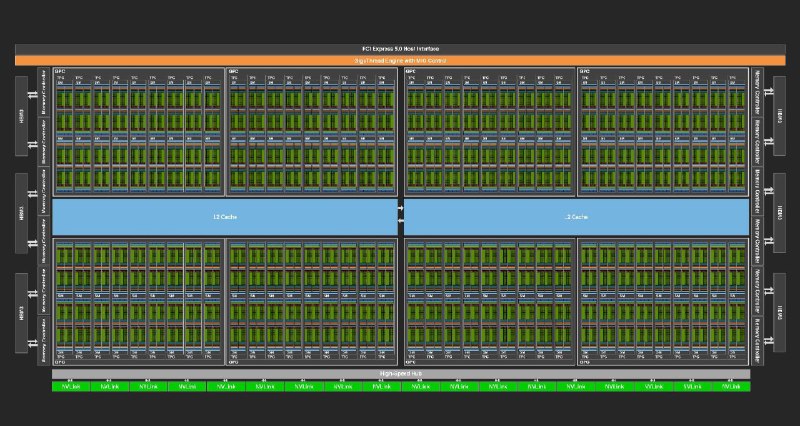

Там nvidia опубликовали статью, а также выложили пост о том, как разработали ChipNeMo - LLM для разработки чипов.

Ну я считаю, что и правильно. Пусть нейронки сами для себя чипы строят, уж они получше кожаных мешков знают, на каком железе им обучаться проще будет.

Вообще звучит пафосно "... can assist one of the most complex engineering efforts: designing semiconductors" в голове сразу рисуется скайнет, который сам для себя разрабатывает процессоры и самостоятельно прокачивается. Но по сути, если заглянуть в саму статью, то примеры использования там приводятся следующие: "Engineering Assistant Chatbot", "EDA Script Generation" (генерация 10-20 строчных скриптов), "Bug Summarization and Analysis". Ну и все. Уже и не так круто выглядит(

Из интересного - пишут, что из-за кастомизации модели под конкретную предметную область удалось существенно снизить количество параметров: с 70 миллиардов в llama-2 до 13 миллиардов в ChipNeMo. То есть если делать модель, заточенную под более конкретные задачи, то можно существенно уменьшить её размер (откупившись парой лет разработки).

[[obsidian]]

BY Миша пишет код

Share with your friend now:

group-telegram.com/misha_writes_code/151