group-telegram.com/kitty_bytes/11

Last Update:

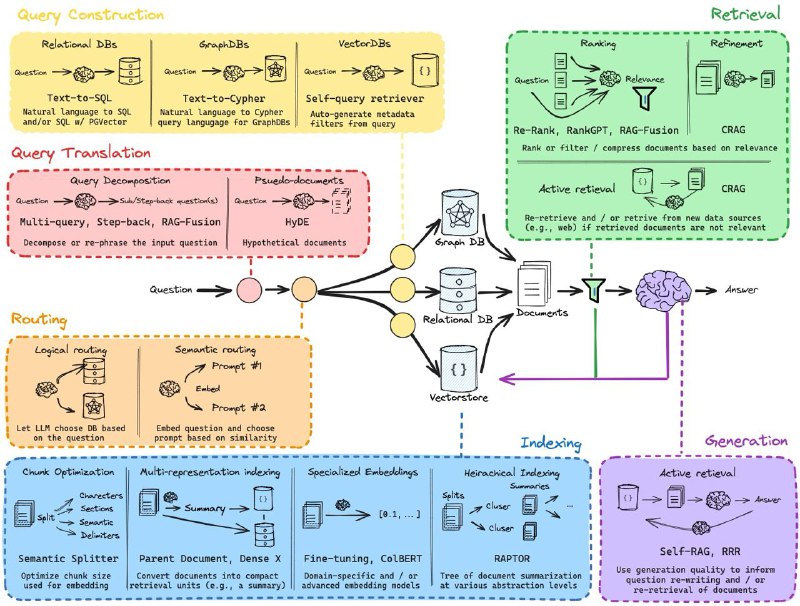

Advanced RAG Pipelines

#rag #context

Исследования 2023 года показали, что длина контекста не сильно помогает LLM давать точные ответы:

- В этой статье показано, что при наличии нерелевантного (мусорного) контекста производительность модели резко снижается

- А вот здесь доказали, что LLM в основном фокусируется на начале контекста и его конце

Поэтому RAG, полагаю, еще некоторое время будет актуален.

Retrieval-Augmented Generation (RAG) помогает по запросу пользователя извлечь наиболее релевантный контекст документов из БД, чтобы подать их в виде контекста в LLM вместе с запросом пользователя. Это помогает модели отвечать на точные вопросы, такие как "Какое влияние оказали первые реформы Столыпина на экономику Российской Империи?".

Краткое содержание разобранных архитектур и когда они применяются:

- Document Hierarchies - когда необходима точность сравнения нескольких фактов из большой БД документов

- Knowledge Graphs - в случае семантических соединений объектов друг с другом в БД и когда одинаково важны сущности данных и их отношения с другими объектами

- Hypothetical Document Embeddings - подходит в случае "общих" запросов и «холодного старта» без первоначального контекста

- Contextual Compressors & Filters - используется при необходимости фильтрации лишнего контекста для входа в LLM

- Multi-Query Retrieval - когда пользователь ничего не знает о запрашиваемом объекте и составляет запрос общего характера

- RAG-Fusion - когда необходимо устранить разрыв между тем,

что пользователь явно задает в запросе и тем, что он собирается спрашивать

- Multimodal RAG - используется в мультимодальных LLM

Читать больше в Teletype