🧮 Модели решают математику… но не совсем

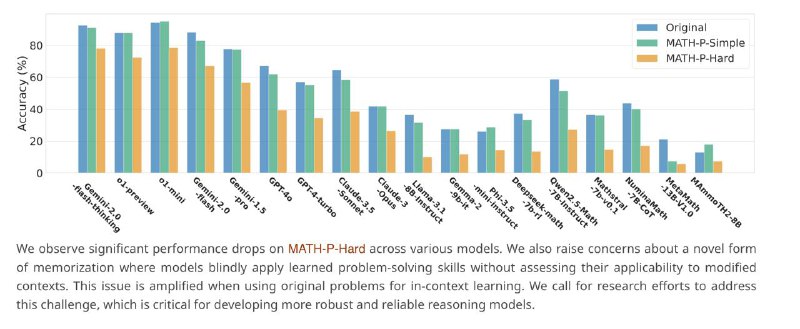

Исследователи предложили новый бенчмарк — MATH-Perturb, чтобы проверить: языковые модели действительно "умеют" решать задачи по математике или просто запоминают шаблоны?

📌 Что сделали: Они взяли 279 самых сложных задач из датасета MATH (уровень 5) и создали две версии для каждой:

MATH-P-Simple — простая пертурбация (вопрос формулируется иначе, но суть и метод решения не меняется).

MATH-P-Hard — сложная пертурбация (незаметное изменение, которое требует другого метода решения и более глубокого понимания).

🧠 Что показали тесты: Модели легко решают оригинальные и "простые" пертурбированные задачи — даже если используют "шорткат-решения" (по сути, угадывают по шаблону).

Но на сложных пертурбациях они резко проваливаются. Шорткат больше не работает, и модель теряется.

📊 Вывод: Многие языковые модели, включая самые продвинутые, не понимают математику в глубоком смысле. Они подбирают шаблон, а не рассуждают.

MATH-Perturb — отличный способ отделить память от мышления.

🔗 Подробнее: https://arxiv.org/abs/2404.01649

🔗 Бенчмарк: https://math-perturb.github.io/

@data_math

Исследователи предложили новый бенчмарк — MATH-Perturb, чтобы проверить: языковые модели действительно "умеют" решать задачи по математике или просто запоминают шаблоны?

📌 Что сделали: Они взяли 279 самых сложных задач из датасета MATH (уровень 5) и создали две версии для каждой:

MATH-P-Simple — простая пертурбация (вопрос формулируется иначе, но суть и метод решения не меняется).

MATH-P-Hard — сложная пертурбация (незаметное изменение, которое требует другого метода решения и более глубокого понимания).

🧠 Что показали тесты: Модели легко решают оригинальные и "простые" пертурбированные задачи — даже если используют "шорткат-решения" (по сути, угадывают по шаблону).

Но на сложных пертурбациях они резко проваливаются. Шорткат больше не работает, и модель теряется.

📊 Вывод: Многие языковые модели, включая самые продвинутые, не понимают математику в глубоком смысле. Они подбирают шаблон, а не рассуждают.

MATH-Perturb — отличный способ отделить память от мышления.

🔗 Подробнее: https://arxiv.org/abs/2404.01649

🔗 Бенчмарк: https://math-perturb.github.io/

@data_math

group-telegram.com/data_math/736

Create:

Last Update:

Last Update:

🧮 Модели решают математику… но не совсем

Исследователи предложили новый бенчмарк — MATH-Perturb, чтобы проверить: языковые модели действительно "умеют" решать задачи по математике или просто запоминают шаблоны?

📌 Что сделали: Они взяли 279 самых сложных задач из датасета MATH (уровень 5) и создали две версии для каждой:

MATH-P-Simple — простая пертурбация (вопрос формулируется иначе, но суть и метод решения не меняется).

MATH-P-Hard — сложная пертурбация (незаметное изменение, которое требует другого метода решения и более глубокого понимания).

🧠 Что показали тесты: Модели легко решают оригинальные и "простые" пертурбированные задачи — даже если используют "шорткат-решения" (по сути, угадывают по шаблону).

Но на сложных пертурбациях они резко проваливаются. Шорткат больше не работает, и модель теряется.

📊 Вывод: Многие языковые модели, включая самые продвинутые, не понимают математику в глубоком смысле. Они подбирают шаблон, а не рассуждают.

MATH-Perturb — отличный способ отделить память от мышления.

🔗 Подробнее: https://arxiv.org/abs/2404.01649

🔗 Бенчмарк: https://math-perturb.github.io/

@data_math

Исследователи предложили новый бенчмарк — MATH-Perturb, чтобы проверить: языковые модели действительно "умеют" решать задачи по математике или просто запоминают шаблоны?

📌 Что сделали: Они взяли 279 самых сложных задач из датасета MATH (уровень 5) и создали две версии для каждой:

MATH-P-Simple — простая пертурбация (вопрос формулируется иначе, но суть и метод решения не меняется).

MATH-P-Hard — сложная пертурбация (незаметное изменение, которое требует другого метода решения и более глубокого понимания).

🧠 Что показали тесты: Модели легко решают оригинальные и "простые" пертурбированные задачи — даже если используют "шорткат-решения" (по сути, угадывают по шаблону).

Но на сложных пертурбациях они резко проваливаются. Шорткат больше не работает, и модель теряется.

📊 Вывод: Многие языковые модели, включая самые продвинутые, не понимают математику в глубоком смысле. Они подбирают шаблон, а не рассуждают.

MATH-Perturb — отличный способ отделить память от мышления.

🔗 Подробнее: https://arxiv.org/abs/2404.01649

🔗 Бенчмарк: https://math-perturb.github.io/

@data_math

BY Математика Дата саентиста

Share with your friend now:

group-telegram.com/data_math/736