group-telegram.com/datastorieslanguages/252

Last Update:

Announcing the results of the inaugural AlgoPerf: Training Algorithms benchmark competition

Какое-то время назад объявили соревнование с целью найти алгоритмы тренировки, которые бы могли ускорять разные модели.

https://mlcommons.org/2024/08/mlc-algoperf-benchmark-competition/

"""The AlgoPerf: Training Algorithms benchmark evaluates the time training required for different training algorithms across multiple realistic deep learning workloads when running on a fixed hardware configuration.

Scoring involved over 4000 individual training runs across the 14 workloads used in the benchmark."""

Было два бенчмарка.

Первый - с возможностью external tuning. Победила команда с сабмитом "Distributed Shampoo" из Meta и Samsung AI.

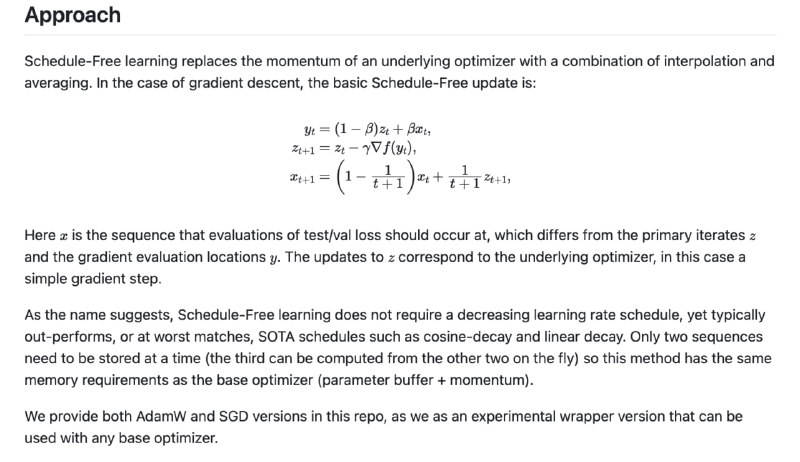

Второй - чисто self-tuning. Из всех сабмитов только один побил бейзлайн - "Schedule Free AdamW" от Meta.

По факту это звучит довольно круто - оптимизатор, который можно успешно использовать без scheduler. [Код](https://github.com/facebookresearch/schedule_free) доступен. Дефолтная реализация на PyTorch, но есть и вариант на Jax.

#datascience

BY Data, Stories and Languages

Share with your friend now:

group-telegram.com/datastorieslanguages/252