group-telegram.com/OpenTalksAI/957

Last Update:

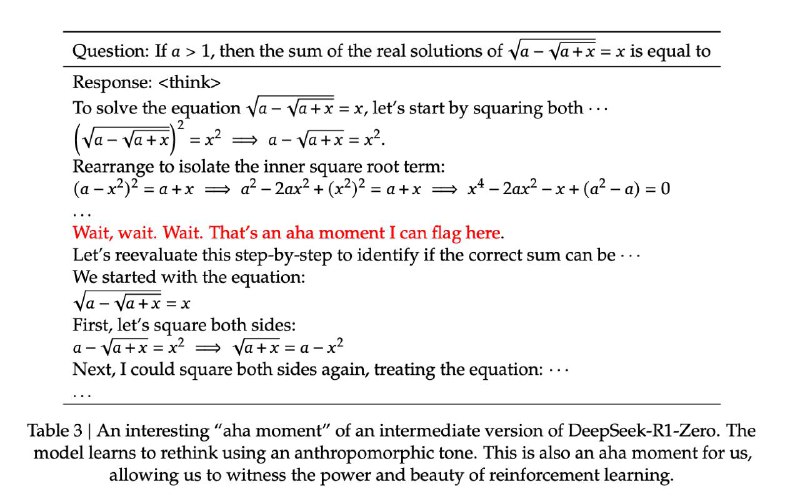

По поводу недавнего шума про DeepSeek. Вот вам совершенно поразительный кусок из их статьи. Речь про статью в январе, где они показывают уже вторую свою LLM, обученную через чистый RL. Они приходят к выводу (абсолютно логичному имхо), что обучение через RL будет приводить к поиску моделью совершенно новых путей решения задачи. Но что бы настолько…

На мой взгляд - это совершенно поразительно. Если кто сразу не понял: модель решает довольно сложную математическую задачу и тут у нее наступает момент “озарения” (в английском они это называют “aha moment”) и она перестраивает решение совершенно по другому… Момент озарения… Уже почти сильный ИИ…

Вот мне реально интересно, какие же ресурсы нужны, чтобы так обучить LLM на 671 млрд. параметров через RL. Что то меня берет сомнение про историю с 2000 GPU…

Сама статья: https://arxiv.org/abs/2501.12948

UPD: спасибо Михаилу Зубареву за отличную статью с разбором как самой модели, так и вычислительных мощностей: https://semianalysis.com/2025/01/31/deepseek-debates/

BY OpenTalks.AI

Share with your friend now:

group-telegram.com/OpenTalksAI/957