Mistral выпустили две новые 7B модели

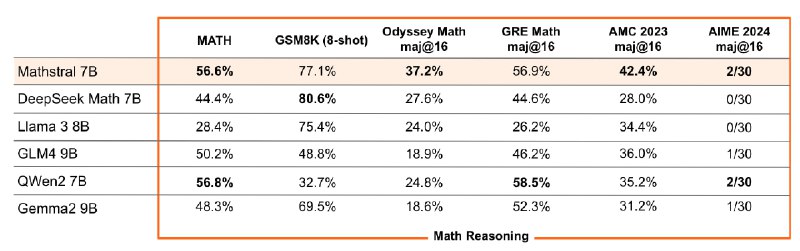

MathΣtral - тюн Mistral 7B, ориентированный на математику и технические дисциплины. На бенчах заметно лучше конкурентов среди открытых математических LLM, но до закрытых моделей всё ещё далеко - специализированные на математике варианты Gemini 1.5 Pro на MATH выдают за 90%.

Создали модель в коллаборации с Project Numina, победителями недавнего AIMO Progress Prize, где модели соревновались в решении задач с международной математической олимпиады (IMO). На том соревновании первые 4 места заняли тюны DeepSeek Math 7B, видимо, Mistral захотели своего конкурента.

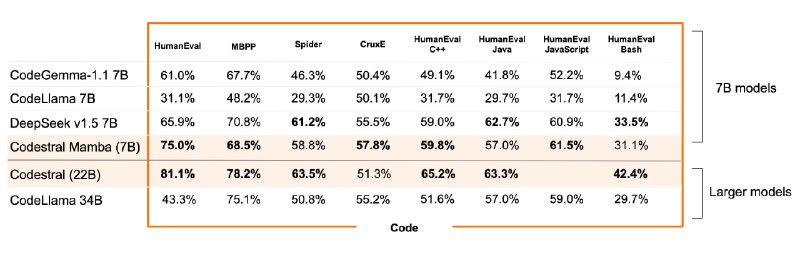

Codestral Mamba - модель для кода, основанная на архитектуре Mamba V2, первый не трансформер который натренили в Mistral.

Результаты неплохие, но результатами бенчей слегка манипулируют - сравнивают с довольно старыми моделями, а с сильными конкурентами, вроде Llama 3 8B и DeepSeek Coder V2 Lite - нет. Результат Llama 3 8B на HumanEval выше чем у других моделей с которыми сравнивают Codestral. А DeepSeek Coder V2 Lite на HumanEval обгоняет не только Codestral Mamba, но и Codestral 22B.

Mamba, в теории, обещает "линейный" инференс с "бесконечным контекстом. Конкурентов трансформерам всегда интересно видеть, но я пока что не видел нормальных тестов контекста более чем 16к токенов, так что отношусь к архитектуре скептически. Если хотите, могу написать про неё поподробнее.

@ai_newz

MathΣtral - тюн Mistral 7B, ориентированный на математику и технические дисциплины. На бенчах заметно лучше конкурентов среди открытых математических LLM, но до закрытых моделей всё ещё далеко - специализированные на математике варианты Gemini 1.5 Pro на MATH выдают за 90%.

Создали модель в коллаборации с Project Numina, победителями недавнего AIMO Progress Prize, где модели соревновались в решении задач с международной математической олимпиады (IMO). На том соревновании первые 4 места заняли тюны DeepSeek Math 7B, видимо, Mistral захотели своего конкурента.

Codestral Mamba - модель для кода, основанная на архитектуре Mamba V2, первый не трансформер который натренили в Mistral.

Результаты неплохие, но результатами бенчей слегка манипулируют - сравнивают с довольно старыми моделями, а с сильными конкурентами, вроде Llama 3 8B и DeepSeek Coder V2 Lite - нет. Результат Llama 3 8B на HumanEval выше чем у других моделей с которыми сравнивают Codestral. А DeepSeek Coder V2 Lite на HumanEval обгоняет не только Codestral Mamba, но и Codestral 22B.

Mamba, в теории, обещает "линейный" инференс с "бесконечным контекстом. Конкурентов трансформерам всегда интересно видеть, но я пока что не видел нормальных тестов контекста более чем 16к токенов, так что отношусь к архитектуре скептически. Если хотите, могу написать про неё поподробнее.

@ai_newz

❤89👍50🔥23❤🔥1

group-telegram.com/ai_newz/3009

Create:

Last Update:

Last Update:

Mistral выпустили две новые 7B модели

MathΣtral - тюн Mistral 7B, ориентированный на математику и технические дисциплины. На бенчах заметно лучше конкурентов среди открытых математических LLM, но до закрытых моделей всё ещё далеко - специализированные на математике варианты Gemini 1.5 Pro на MATH выдают за 90%.

Создали модель в коллаборации с Project Numina, победителями недавнего AIMO Progress Prize, где модели соревновались в решении задач с международной математической олимпиады (IMO). На том соревновании первые 4 места заняли тюны DeepSeek Math 7B, видимо, Mistral захотели своего конкурента.

Codestral Mamba - модель для кода, основанная на архитектуре Mamba V2, первый не трансформер который натренили в Mistral.

Результаты неплохие, но результатами бенчей слегка манипулируют - сравнивают с довольно старыми моделями, а с сильными конкурентами, вроде Llama 3 8B и DeepSeek Coder V2 Lite - нет. Результат Llama 3 8B на HumanEval выше чем у других моделей с которыми сравнивают Codestral. А DeepSeek Coder V2 Lite на HumanEval обгоняет не только Codestral Mamba, но и Codestral 22B.

Mamba, в теории, обещает "линейный" инференс с "бесконечным контекстом. Конкурентов трансформерам всегда интересно видеть, но я пока что не видел нормальных тестов контекста более чем 16к токенов, так что отношусь к архитектуре скептически. Если хотите, могу написать про неё поподробнее.

@ai_newz

MathΣtral - тюн Mistral 7B, ориентированный на математику и технические дисциплины. На бенчах заметно лучше конкурентов среди открытых математических LLM, но до закрытых моделей всё ещё далеко - специализированные на математике варианты Gemini 1.5 Pro на MATH выдают за 90%.

Создали модель в коллаборации с Project Numina, победителями недавнего AIMO Progress Prize, где модели соревновались в решении задач с международной математической олимпиады (IMO). На том соревновании первые 4 места заняли тюны DeepSeek Math 7B, видимо, Mistral захотели своего конкурента.

Codestral Mamba - модель для кода, основанная на архитектуре Mamba V2, первый не трансформер который натренили в Mistral.

Результаты неплохие, но результатами бенчей слегка манипулируют - сравнивают с довольно старыми моделями, а с сильными конкурентами, вроде Llama 3 8B и DeepSeek Coder V2 Lite - нет. Результат Llama 3 8B на HumanEval выше чем у других моделей с которыми сравнивают Codestral. А DeepSeek Coder V2 Lite на HumanEval обгоняет не только Codestral Mamba, но и Codestral 22B.

Mamba, в теории, обещает "линейный" инференс с "бесконечным контекстом. Конкурентов трансформерам всегда интересно видеть, но я пока что не видел нормальных тестов контекста более чем 16к токенов, так что отношусь к архитектуре скептически. Если хотите, могу написать про неё поподробнее.

@ai_newz

BY эйай ньюз

Share with your friend now:

group-telegram.com/ai_newz/3009