group-telegram.com/machinelearning_interview/1685

Last Update:

⚡️ Проект llama-3.2-from-scratch, созданный пользователем rasbt (Себастьян Рашка), представляет собой реализацию модели Llama 3.2 на языке PyTorch с нуля.

Цель проекта — предоставить понятный и минималистичный код для изучения и исследования архитектуры больших языковых моделей (LLM).

Основные особенности проекта:

- Простота и доступность кода: Реализация оптимизирована для читаемости, что делает её подходящей для образовательных целей и исследований.

- Минимальные зависимости: Для работы требуются только библиотеки torch, tiktoken и blobfile, что упрощает установку и использование.

- Предоставление предобученных весов: В репозитории доступны веса моделей, конвертированные из официальных весов, предоставленных компанией Meta. Это позволяет пользователям сразу приступить к экспериментам без необходимости обучать модели с нуля.

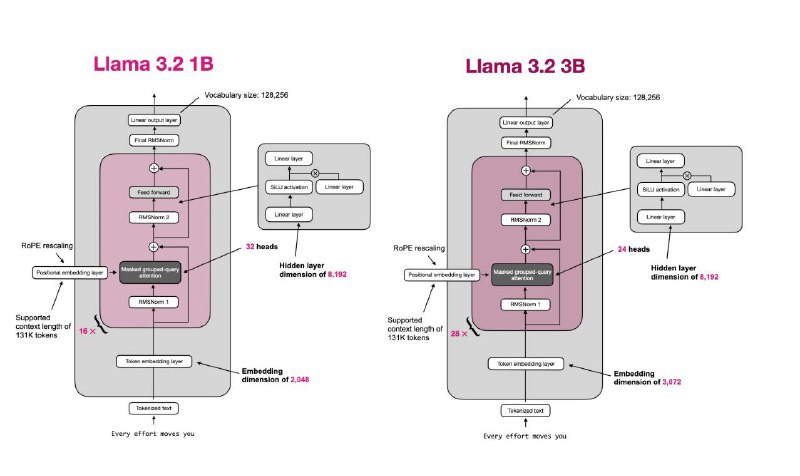

- Гибкость в выборе моделей: Поддерживаются различные версии моделей Llama 3.2, включая базовые и инструкционные варианты с 1 и 3 миллиардами параметров.

- Примеры использования: Включены примеры кода для загрузки моделей, настройки токенизатора и генерации текста, что облегчает начало работы с проектом.

Важно отметить, что предоставленные веса моделей были конвертированы из официальных весов Meta. Для получения оригинальных весов и информации о лицензии рекомендуется обратиться к официальным репозиториям Meta на Hugging Face.

В целом, llama-3.2-from-scratch — это ценный ресурс для разработчиков и исследователей, желающих глубже понять внутреннее устройство современных языковых моделей и экспериментировать с их архитектурой.

https://huggingface.co/rasbt/llama-3.2-from-scratch

@machinelearning_interview

BY Machine learning Interview

Share with your friend now:

group-telegram.com/machinelearning_interview/1685