group-telegram.com/nlp_stuff/342

Last Update:

بهبود عملکرد LLM با نشوندادن Chain of Thought غلط

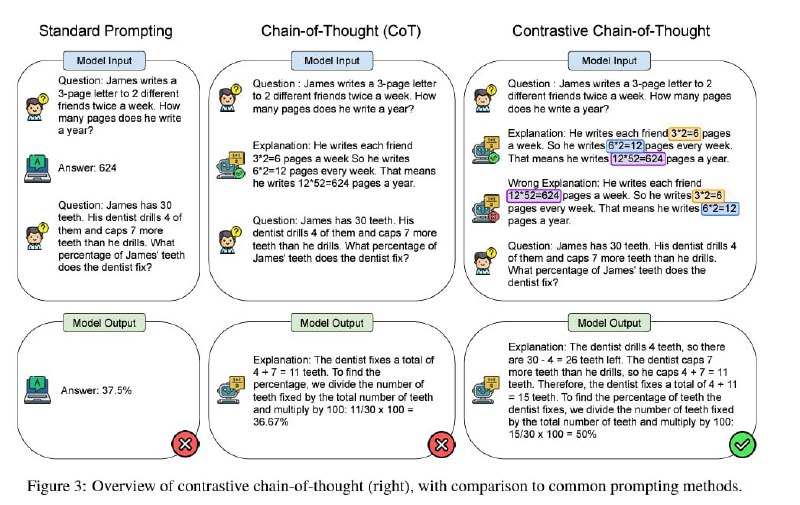

مدلهای زبانی بزرگ با این که کلی از مسائل حوزه پردازش زبان رو درنوردیدند ولی همچنان در برخی مسائل با فاز reasoningطور (مثل مثلا حل مسائل ریاضی) دچار مشکلات جدی هستند. یکی از راهحلهای پیشنهادشده برای بهبود عملکرد این مدلها روی این مسائل، راهکار Chain-of-Thought Prompting (به اختصار CoT) هست. تو این راهکار وقتی میخوایم یک مساله را به صورت few-shot به LLM توضیح بدیم عوض این که در exampleهامون صرفا جواب آخر رو بنویسیم و میایم و مرحله به مرحله نحوه رسیدن به جواب رو توضیح میدیم و این جوری مدل هم وقتی میخواد به کوئری ما پاسخ بده به نوعی مجبور میشه که مرحله به مرحله جواب رو بنویسه. آزمایشات نشون داده که باعث میشه درصد جوابهای پایانی درستی که میده بیشتر بشه.

حالا یک مقاله اومده و یک ایده به نام contrastive chaint of thought prompting رو مطرح کرده. تو این ایده، علاوه بر این که CoT درست به مدل داده میشود بهش CoT اشتباه هم نشون داده میشه و آزمایشات مقاله نشون میده که این ایده نشون دادن CoT غلط در کنار CoT باعث میشه تا عملکرد LLM باز هم بهبود پیدا کنه.

لینک مقاله:

https://arxiv.org/abs/2311.09277

#paper

#read

@nlp_stuff

BY NLP stuff

Share with your friend now:

group-telegram.com/nlp_stuff/342