group-telegram.com/savostyanov_dmitry/499

Last Update:

Разбираем Tech Report про OpenAI Sora

Раньше у text-to-video моделей возникала проблема с консистентностью кадров. Например, вы просите сгенерировать девушку с развивающимися волосами и, если повезет, получаете видео, где лицо плывет, волосинки телепортируются в пространстве, прическа в целом живет своей жизнью.

Вторая проблема заключалась в том, что модели могли генерировать короткие видео продолжительностью в несколько секунд и делали это в квадратном разрешении (условно 256х256).

Что предлагают ребята из OpenAI?

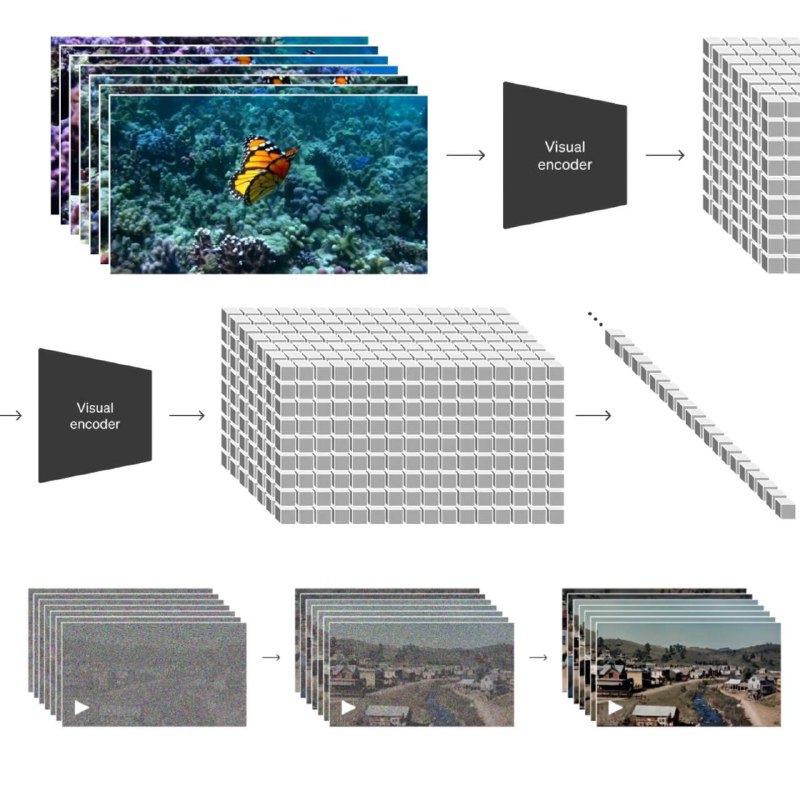

Видео разбиваем на патчи в пространстве-времени. Идея уходит корнями в Vision Transformer (ViT). Только здесь патчи скорее всего не просто 16x16 участки изображения, но стопки (тензоры) таких изображений для нескольких подряд идущих кадров.

Основную работу выполняет диффузионная модель, которая берет на вход случайный шум и итеративно превращает его в пространственно-временные патчи. Подробнее про диффузионные модели можете почитать здесь.

Видео в высоком разрешении весят много. Память в видеокартах ограничена. Поэтому модель использует Encoder, который сжимает видео в латентное пространство меньшей размерности, диффузия идет в нем, а дальше результат разжимается в привычные нам кадры с пикселями с помощью Decoder. Все точно также как в случае с VAE в Stable Diffusion.

Обучение идет не просто на видео, но на парах видео + текстовое описание. Причем описания апскейлятся с помощью GPT-4 по аналогии с тем, как это делалось в DALL-E 3. Вот мой пост с объяснением.

На выходе получается мощная нейросетка, которая умеет:

- генерировать видео по текстовому описанию

- дополнять видео (модель генерирует продолжение)

- превращать изображения в видео (т.к. изображение — это видео из 1 кадра)

- редактировать видео с помощью текстовых промптов. Например, изменять сеттинг (стиль)

- бесшовно склеивать видео. Вы подаете 2 ролика, а модель генерирует интерполяцию между ними

От OpenAI мало технических подробностей. Чтобы лучше понимать, как все работает, советую почитать статью Motion Diffusion Model (MDM)

BY Дмитрий Савостьянов Вещает

Share with your friend now:

group-telegram.com/savostyanov_dmitry/499