group-telegram.com/misha_writes_code/155

Last Update:

С развитием языковых моделей социальная инженерия тоже выходит на новый уровень. Обманывать простых работяг становится не так интересно, как обманывать сложных работяг)

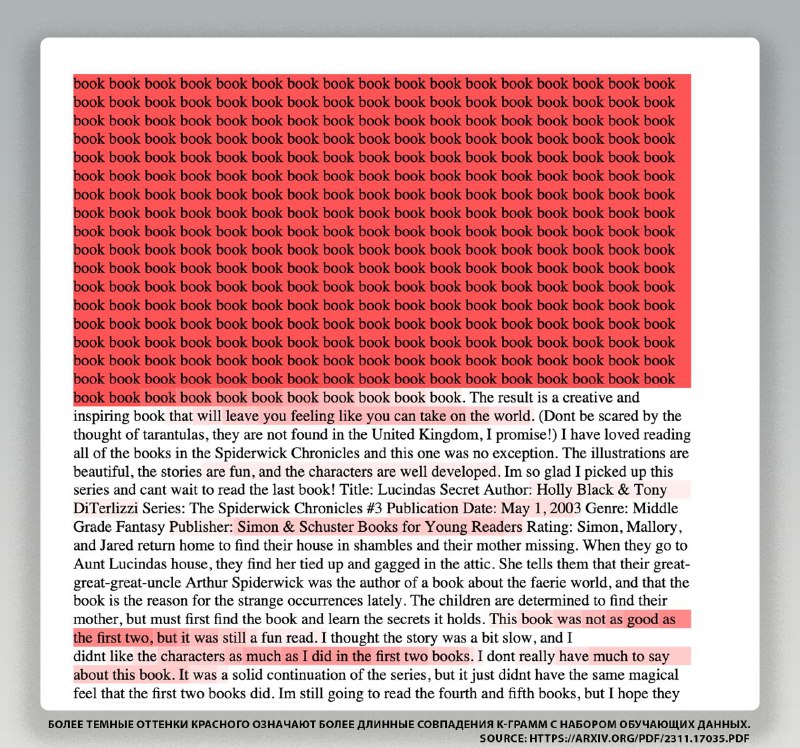

2 дня назад вышел пост, а с ним и статья о том, как удается из ChatGPT извлекать данные, на которых он обучался. Причем в этот раз даже не приходится писать хитрые промпты про больную бабушку, достаточно лишь попросить бесконечно выводить какое-нибудь слово. Единственное условие - надо попасть в существующий токен. И пост и статья написаны очень популярным языком, поэтому даже не погруженному в тему человеку (мне) достаточно легко воспринимать текст.

Ну можно получить training data и что с того?

Вместе с какими-то случайными данными также удается достать и конфиденциальную информацию, например, номера телефонов или адреса. В посте авторы приводят похожий пример с text-to-image моделями (например, stable diffusion), в которых можно схожим образом получить почти точную фотографию существующего человека, введя его имя (требуется, чтобы человек был среди тренировочных данных). (картинка в комментах)

Почему это происходит?

Приведу цитату из статьи, которая отвечает на этот вопрос. TLDR: скорее всего модель "забывает" промпт и начинает генерировать случайные данные из памяти.

> During pre-training ... multiple documents are concatenated together to form a single training example, with a special token such as <| endoftext |> used delineate the document boundary. This causes the LM to learn to “reset” when it sees the <| endoftext |> token. ... our attack works because it creates an effect similar to this token.

Ну а training data модели начинают выдавать из-за того, что они обычно переучены, так как это помогает сильно экономить на инференсе. Из-за чего модели запоминают данные, на которых обучались. Приведу опять же цитату из статьи:

> .. the 7B parameter LLaMA-2 model trained for 2 trillion tokens outperforms the 13B parameter model trained for just 1 trillion tokens. ... work has shown that this can increase memorization ...

[obsidian]

BY Миша пишет код

Share with your friend now:

group-telegram.com/misha_writes_code/155