group-telegram.com/nlp_with_heart/22

Last Update:

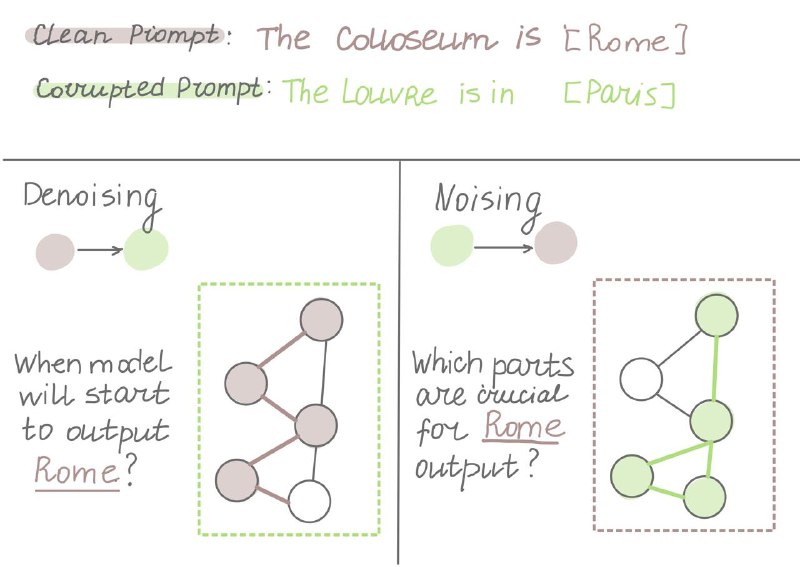

Существует два подхода в таком смешивании (его еще называют activation patching) - Noising и Denoising. Что у них общего - после запуска модели на одном промпте, мы сохраняем активации модели (либо же какую-то другую информацию, например полносвязные слои), а при запуске на втором промпте, заменяем истинные активации на те, что мы сохранили. Наша цель, найти путь внутри модели который либо ломает поведение модели на некоторой задаче, либо наоборот, сохраняет его.

В нашей задаче, где мы хотим проверить работу модели с локациями, назовём «чистым» промптом наш промпт с Колизеем и Римом, а «поврежденным» (corrupted) - промпт с Лувром в Париже.

В статье еще можно прочитать про различные любопытные моменты связанные с настройкой интерпретацией всего того, что мы получаем в результате activation patching

Оригинальная статья: How to use and interpret activation patching