group-telegram.com/machinelearning_interview/1850

Last Update:

🤖 Почему модели лучше отвечают на вопросы по тексту, чем по изображениям — и как это исправить?

Vision-Language модели (VLMs) сильно хуже справляются с вопросами про картинки (*«Сколько книг на изображении?»*), чем с теми же вопросами по тексту (*«Сколько книг в описании?»*). И нашли способ улучшить результат на +4.6%, закрыв треть разрыва между модальностями! Вот что они сделали 👇

🔬 Они разделили вход на три части:

• Данные (изображение или текст),

• Вопрос (*how many…*),

• Ответ (предсказание последнего слова).

🧠 Что нашли:

1️⃣ Мозги у модели разные для текста и картинок — цепочки внимания и нейроны почти не совпадают (всего ~18%). Особенно в частях, где обрабатываются данные и вопрос.

2️⃣ Часть, отвечающая за генерацию ответа, похожа — можно даже подменить её между модальностями, и модель почти не теряет в точности.

3️⃣ Часть, которая "смотрит" на данные — строго модальная. Визуальный поток информации идёт по другому пути, и замена разрушает результат.

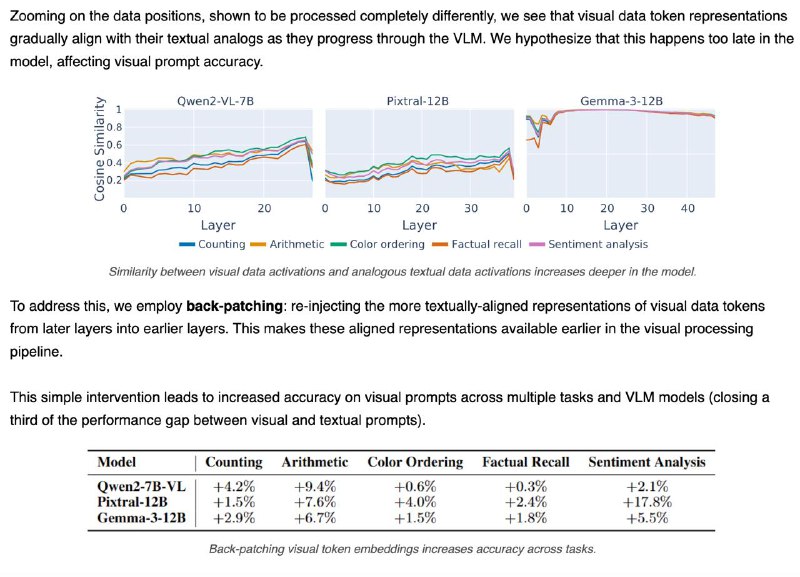

4️⃣ Проблема в том, что изображение “становится понятным” слишком поздно. В поздних слоях визуальные данные уже похожи на текстовые — но модель не успевает этим воспользоваться.

💡 Решение: "перемотать" визуальные данные из поздних слоёв обратно в ранние (back-patching) — это помогает модели раньше "понять" картинку.

📈 Результат: +4.6% точности при ответах на вопросы по изображению — и треть разрыва с текстом закрыта!

🧩 Вывод: архитектура не виновата. Просто визуальные данные нужно правильно "подать" — и VLM начинает думать почти как человек.

@machinelearning_interview