group-telegram.com/machinelearning_books/1016

Create:

Last Update:

Last Update:

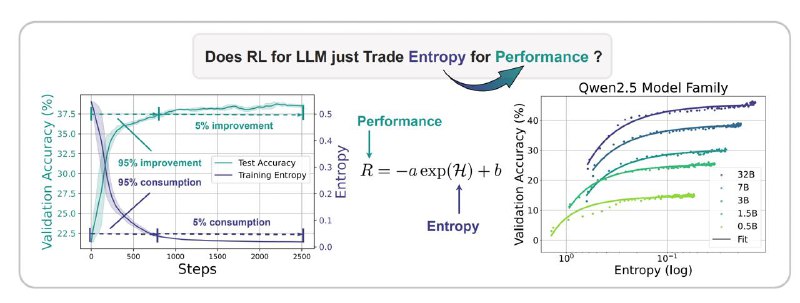

💡 The Entropy Mechanism of Reinforcement Learning for Reasoning Language Models

Почему политики в RL "зависают" и как это исправить?

Когда мы обучаем большие языковые модели (LLMs) через обучение с подкреплением (RL), есть одна большая проблема:

📉 Политика слишком рано "замыкается" и перестаёт исследовать новые действия.

Это называют коллапсом энтропии — модель быстро теряет разнообразие в своих решениях и больше не пробует что-то новое.

🔬 Учёные обнаружили:

🔗 Есть закономерность:

Когда энтропия падает, качество (reward) тоже перестаёт расти.

Формула:

R = -a * e^H + b

То есть: меньше разнообразия → предсказуемый потолок качества.

🤔 Почему так происходит?

Потому что в RL-алгоритмах (как Policy Gradient) модель усиливает те действия, которые уже приносят награду, и почти не обновляет остальное.

В результате:

- Энтропия падает

- Модель перестаёт исследовать

- Качество "застывает"

💡 Как это исправить?

Авторы предложили 2 простых приёма:

1. Clip-Cov — ограничить обновление токенов, где политика слишком уверена

2. KL-Cov — добавить штраф на такие уверенные токены, чтобы сохранить разнообразие

📈 Результат:

Эти методы удерживают политику в исследовательском режиме дольше и позволяют достичь лучших результатов на практике.

🔗 Если ты работаешь с RLHF, LLM или reasoning — это отличная идея для устойчивого масштабирования.

📌 Читать

BY Машиннное обучение | Наука о данных Библиотека

Share with your friend now:

group-telegram.com/machinelearning_books/1016